- Het grote taalmodel PaLM 2 van Google gebruikt bijna vijf keer zoveel tekstuele gegevens voor training als zijn voorganger, LLM, heeft CNBC geleerd.

- Bij de aankondiging van de PaLM 2 vorige week zei Google dat het model kleiner is dan de vorige PaLM, maar gebruik maakt van efficiëntere ’technologie’.

- Het gebrek aan transparantie over trainingsdata in AI-modellen is een steeds hot topic geworden onder onderzoekers.

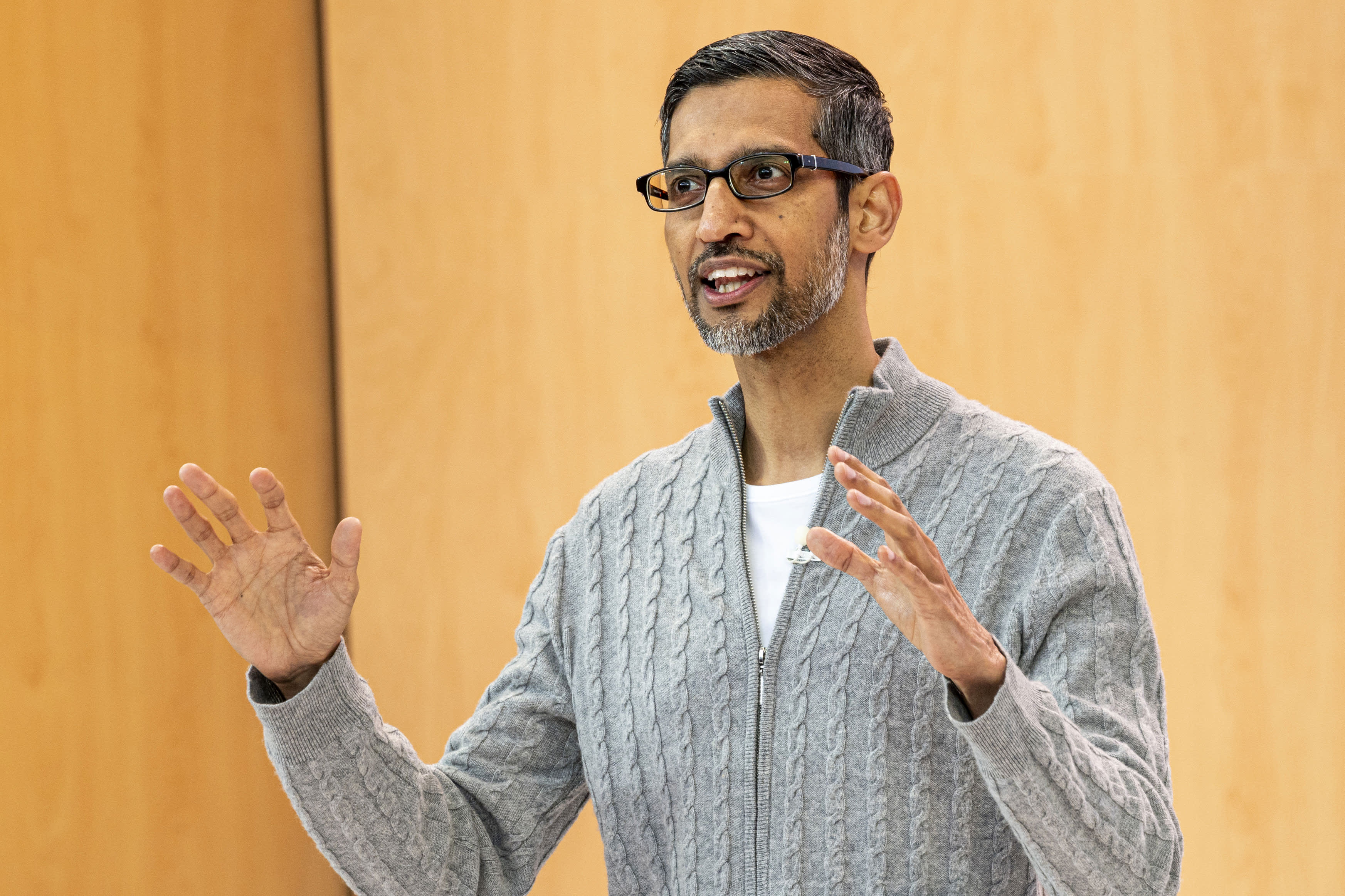

Sundar Pichai, CEO, Alphabet Inc. , tijdens de Google I/O Developers Conference in Mountain View, Californië, op woensdag 10 mei 2023.

David Paul Morris | bloeiberg | Getty-afbeeldingen

CNBC heeft vernomen dat het nieuwe grote taalmodel van Google, dat het bedrijf vorige week aankondigde, bijna vijf keer zoveel trainingsgegevens gebruikt als zijn voorganger uit 2022, waardoor het meer geavanceerde codeer-, wiskundige en creatieve schrijftaken kan uitvoeren.

PaLM 2, het nieuwe LLM-model (public-use large language) van het bedrijf dat werd onthuld op Google I/O, is getraind op 3,6 biljoen tokens, volgens interne documenten die door CNBC zijn ingezien. Tokens, woordreeksen, zijn een belangrijke bouwsteen voor het trainen van LLM, omdat ze het model leren het volgende woord te voorspellen dat in een reeks zal verschijnen.

De vorige versie van Google van PaLM, wat staat voor Pathways Language Model, werd uitgebracht in 2022 en getraind op 780 miljard tokens.

Hoewel Google erop gebrand was om de kracht van zijn AI-technologie te laten zien en hoe deze geïntegreerd kon worden in zoeken, e-mails, tekstverwerking en spreadsheets, was het bedrijf niet bereid om het volume of andere details van zijn trainingsgegevens te publiceren. OpenAI, de innovator van door Microsoft ondersteunde ChatGPT, heeft ook de details van de nieuwste LLM-taal genaamd GPT-4 geheim gehouden.

De bedrijven zeggen dat de reden voor het gebrek aan openbaarmaking het competitieve karakter van het bedrijf is. Google en OpenAI haasten zich om gebruikers aan te trekken die misschien naar informatie willen zoeken met behulp van chatbots in plaats van traditionele zoekmachines.

Maar terwijl de AI-wapenwedloop voortduurt, roept de onderzoeksgemeenschap op tot meer transparantie.

Sinds de onthulling van PaLM 2 heeft Google gezegd dat het nieuwe model kleiner is dan eerdere LLM’s, wat belangrijk is omdat het betekent dat de technologie van het bedrijf efficiënter wordt terwijl complexere taken worden uitgevoerd. PaLM 2 is volgens interne documentatie getraind op 340 miljard parameters, wat een indicatie is van de complexiteit van het model. De initiële PaLM is getraind op 540 miljard parameters.

Google gaf niet meteen commentaar op dit verhaal.

Google Hij zei In een blogpost over PaLM 2 gebruikt het model een “nieuwe techniek” genaamd Computational Scale Optimization. Dit maakt de LLM “efficiënter met betere algehele prestaties, inclusief snellere gevolgtrekking, minder serviceparameters en lagere servicekosten.”

Met de aankondiging van PaLM 2 bevestigde Google eerdere CNBC-rapporten dat het model in 100 talen is getraind en een breed scala aan taken uitvoert. Het wordt al gebruikt voor 25 functies en producten, waaronder de experimentele chatbot Bard van het bedrijf. Het is verkrijgbaar in vier maten, van klein naar groot: Gecko, Otter, Bison en Unicorn.

PaLM 2 is krachtiger dan elk bestaand model, gebaseerd op openbare bekendmakingen. LLM op Facebook heet LLaMA, dat is aankondigen In februari werd het getraind op 1,4 biljoen tokens. De laatste keer dat OpenAI het trainingsvolume van ChatGPT deelde, was met GPT-3, toen het bedrijf zei dat het in die tijd 300 miljard codes had getraind. OpenAI heeft GPT-4 in maart uitgebracht en zei dat het “prestaties op menselijk niveau” laat zien in verschillende professionele tests.

LaMDA, LLM-gesprek dat Google voet Twee jaar geleden en gepromoot in februari samen met Bard, is het getraind op 1,5 biljoen tokens, volgens de laatste documenten gezien door CNBC.

Naarmate nieuwe AI-toepassingen snel mainstream worden, neemt ook het debat over de onderliggende technologie toe.

Mehdi Elmohamady, Senior Research Scientist bij Google, In februari nam hij ontslag Over het gebrek aan transparantie van het bedrijf. Op dinsdag getuigde Sam Altman, CEO van OpenAI, tijdens een hoorzitting van de subcommissie voor privacy en technologie van de Senaat en was hij het met de wetgevers eens dat er een nieuw systeem nodig is om met AI om te gaan.

“Voor een technologie die zo nieuw is, hebben we een nieuw raamwerk nodig”, zei Altmann. “Bedrijven zoals het onze hebben zeker een grote verantwoordelijkheid voor de tools die we de wereld in sturen.”

– Jordan Novette van CNBC heeft bijgedragen aan dit rapport.

Hij kijkt: Sam Altman, CEO van OpenAI, heeft opgeroepen tot AI-stewardship

‘Reader. Furious humble travel enthusiast. Extreme food scientist. Writer. Communicator.’

![De Android 15 Pixel-update wordt officieel gelanceerd in oktober [U] De Android 15 Pixel-update wordt officieel gelanceerd in oktober [U]](https://i0.wp.com/9to5google.com/wp-content/uploads/sites/4/2024/07/Android-15-Beta-4-v4.jpg?resize=1200%2C628&quality=82&strip=all&ssl=1)